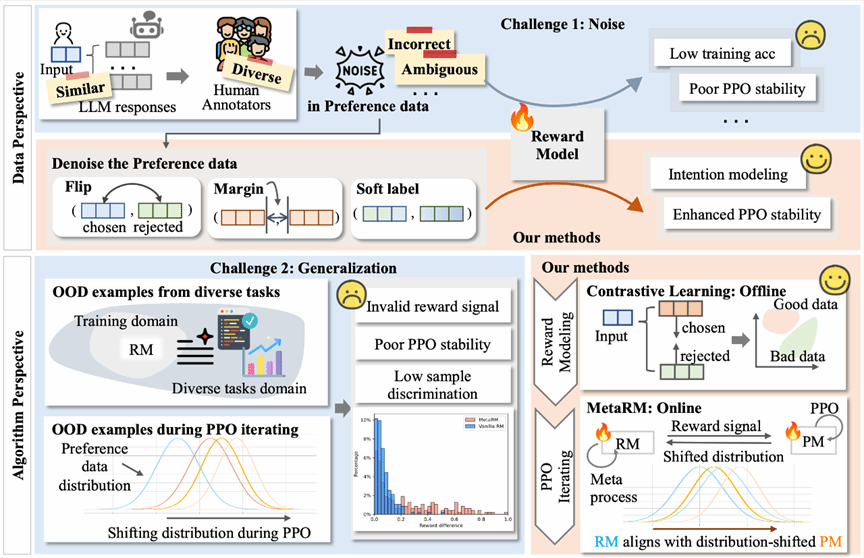

随着 ChatGPT、GPT-4 等大型语言模型的技术创新和广泛应用,这些模型已成为当下的技术热点,革新了我们与机器互动的方式,为各行各业提供了前所未有的模型支持。这些模型在解决复杂问题、自动生成内容和理解复杂指令方面展现出巨大价值。然而这些模型在在对齐人类价值观和偏好方面,仍有所局限。2024年2月,桂韬与自然语言处理实验室团队于深度学习领域国际顶级会议“国际表征学习大会”(The Twelfth International Conference on Learning Representations)发表文章:Improving Generalization of Alignment with Human Preferences through Group Invariant Learning。该文提出了一个全新的技术方法,使基于语言模型的人工智能助手(AI assistants)通过强化学习(RL)在各种数据组或领域中学习一致,并自动将数据分类为不同的组,以最大限度地提高性能差异。该方法自适应地调整探索空间,为更具挑战性的数据分配更多的学习能力,并防止模型对简单数据进行过度优化。实验结果表明,该方法显著提高了训练的稳定性和模型的泛化能力。

链接:https://openreview.net/forum?id=fwCoLe3TAX